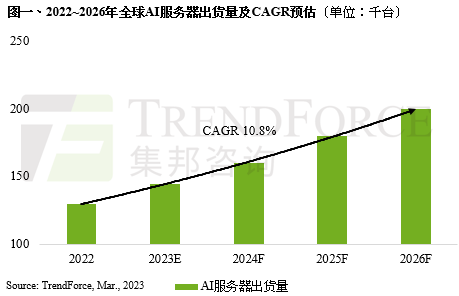

TrendForce集邦咨询观察到始自2018年新兴应用题材的带领下,包含自动驾驶汽车、AIoT与边缘运算,诸多大型云端业者开始大量投入AI相关的设备建设,截至2022年为止,预估搭载GPGPU(General Purpose GPU)的AI 服务器年出货量占整体服务器比重近1%,而2023年预估在ChatBot相关应用加持下,可望再度刺激AI相关领域的活络,预估出货量年成长可达8%;2022~2026年复合成长率将达10.8%。

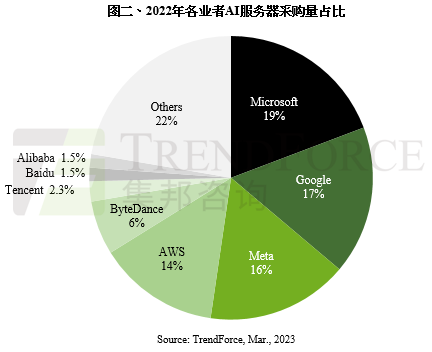

据TrendForce集邦咨询统计,2022年AI服务器采购占比以北美四大云端业者Google、AWS、Meta、Microsoft合计占66.2%为最,而中国近年来随着国产化力道加剧,AI建设浪潮随之增温,以ByteDance的采购力道最为显著,年采购占比达6.2%,其次紧接在后的则是Tencent、Alibaba与Baidu,分别约为2.3%、1.5%与1.5%。

借AI优化自家搜寻引擎,AI需求持续带动HBM存储器成长

在看好AI发展的前景下,Microsoft更是大举投资OpenAI,除了于今年2月推出自家搜寻引擎Bing的强化版,其中融合ChatGPT技术以及与OpenAI合作开发大型语言模型「Prometheus」;Baidu亦于2023年2月宣布将推出相关服务「文心一言(ERNIE Bot)」,初期将以独立软件呈现,后续也将导入搜寻引擎。 以运算规格来看,ChatGPT主要以NVIDIA A100为主,独家使用Microsoft Azure云服务资源。若合并其他Microsoft应用而计,全年Microsoft AI服务器年需求为25,000台。Baidu文心一言采用NVIDIA A800,合并其他应用,Baidu AI服务器年需求约为2,000台。TrendForce集邦咨询分析,以AI运算所需要的server GPU而言,其市场以NVIDIA H100、A100、A800以及AMD MI250、MI250X系列为主,而NVIDIA与AMD的Server GPU占比约8:2。

若聚焦于这些GPU规格,其中因应高频宽运算而使用的HBM(High Bandwidth Memory)更受到市场瞩目。 以位元计算,HBM占整个DRAM市场比重约1.5%,供应商以三星(Samsung)、SK海力士(SK hynix)与美光(Micron)为主。但以NVIDIA使用的HBM3,SK海力士是目前唯一量产的厂商,因此在该规格主导市场,由于生产技术门槛高,对原厂而言属于高毛利产品。

2020-2021年疫情期间由于担心供应链缺料,超额备料下使得HBM年需求成长率特别亮眼,而自2023年起需求成长率在物料调节下有所收敛。TrendForce集邦咨询预估,2023~2025年HBM市场年复合成长率有望成长至40~45%以上。整体而言,伴随全球云端业者逐年增加AI服务器的投入,尽管大环境受高通胀、经济增长放缓冲击,企业、组织对于IT支出转趋保守,但在ChatBot与搜寻引擎应用的带动下,AI相关转型布局仍被视为云端业者投入资本支出的优先项目。

若有兴趣进一步了解并购买TrendForce集邦咨询旗下半导体研究处相关报告与产业数据,请至//www.djgruve.com/research/dram查阅,或洽询service@trendforce.cn